Digitalisierung ist ein Buzz-Word, dass seit Mitte 2017, sehr großes Interesse in Deutschland erfährt. Eine Google-Trends Recherche zeigt einen Anstieg, beginnend im Jahr 2014. Aber was verbirgt sich hinter dem Begriff? Digitalisiert wurde doch schon seit Erfindung des Computers? Diese Artikelserie soll über das Begriffsverständnis aufklären, denn die wissenschaftliche Definition ist besonders wichtig, da hinter dem Begriff der Digitalisierung mehr als nur eine Bedeutung steckt.

Die Geschichte des Computers

Um die Grundlagen rund um die Begriffswelt „Digitalisierung“ zu verstehen, soll zunächst kurz die Entwicklung des Computers betrachtet werden. Konrad Zuse und Helmut Schreyer entwickelten und bauten 1941 den ersten Computer in Berlin. Der Zuse Z3 gilt als einer der ersten programmierbaren Rechner, der einen binären Code verwendete. Damit begründeten die zwei Deutschen den Beginn des digitalen Zeitalters. Es dauerte allerdings noch bis ins Jahr 1971, als der erste Mikroprozessor von Intel patentiert wurde (Vgl. Neugebauer 2018, S. 1).

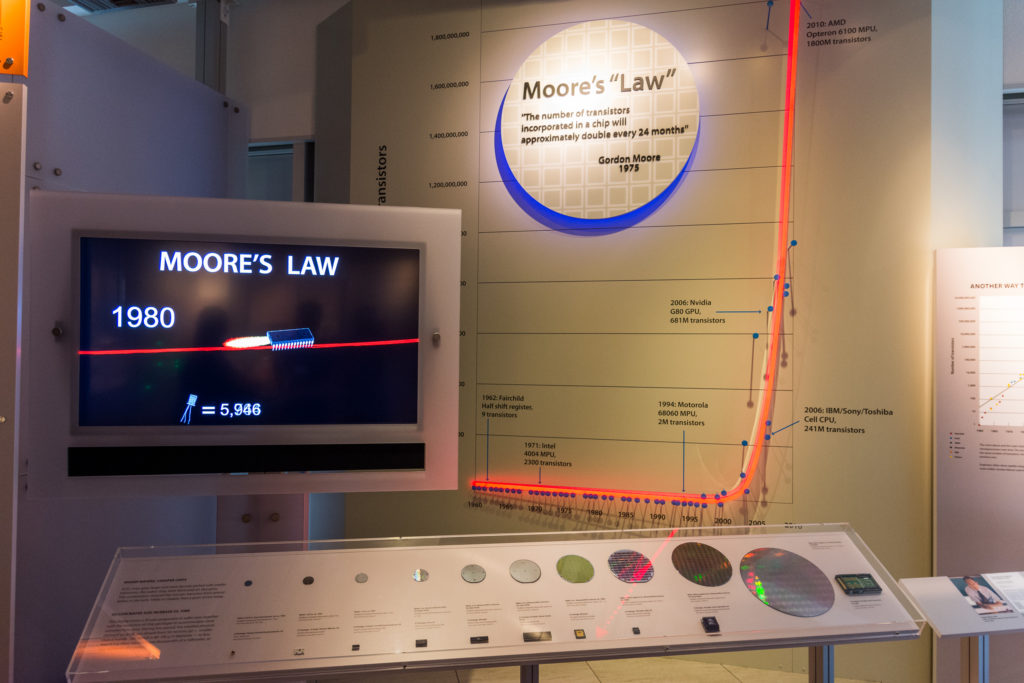

Der Intel Chip enthielt rund 2300 Transistoren. Mit jedem Jahr der Entwicklung wurden die Chips kleiner, schneller und besser. 1994 enthielten Chips von Motorola bereits 2 Millionen Transistoren. Im Jahr 2006 waren es 241 Millionen Transistoren und 2010 1,8 Milliarden Transistoren. 2018 ist die Entwicklung bei rund 12 Milliarden Transistoren angekommen (Vgl. Schadhauser 2018).

Das Mooresche Gesetz

Basierend auf dieser Entwicklung erstellte Gordon Moore (Mitbegründer des Chipherstellers Intel) im Jahr 1965 eine Analyse und Prognose. Dabei stellte er fest, dass sich die Anzahl an Komponenten, die in einem integrierten Schaltkreis verbaut sind, jedes Jahr verdoppelt (Vgl. Brock und Moore 2006, S. 72). 1975 korrigierte er seine etwas zu optimistische Aussage aufgrund neuer Analysen und Werte auf alle zwei Jahre (Vgl. Brock und Moore 2006, S. 74). Seine Aussage ist bekannt unter der Bezeichnung Mooresches Gesetz. Es beschreibt, dass sich die Anzahl der Transistoren in einem Chip ungefähr alle 24 Monate verdoppelt, (siehe Abbildung 1).

Moores Extrapolation hat bisher weitestgehend seine Gültigkeit behalten, auch wenn über die genaue Auslegung dieser Regel noch diskutiert wird. Zum fünfzigsten Geburtstag von Intel im Jahr 2018 wurde sogar das Ende von „Moore’s Law“ (Vgl. Schadhauser 2018.) angekündigt, doch veranschaulicht dieses Gesetz eindrucksvoll, mit welcher Dynamik sich die Technik in den letzten Jahrzehnten entwickelt hat. Beispielsweise ist das iPad2 von Apple so leistungsfähig wie der weltweit beste Supercomputer Cray2 aus dem Jahr 1985 (Vgl. Markoff 2011).

Neue Fertigungsverfahren für Chips ermöglichen immer kleinere Strukturen. Die physikalischen Grenzen der Siliziumtechnologie sind mittlerweile fast erreicht. Laut IBM sind Querschnitte der Leiterbahnen kleiner als 5 Nanometer nicht realisierbar, da sonst die Quantenmechanik das Teilchenverhalten durcheinanderbringt. Der Forschungsfokus der Hersteller geht deshalb weg von weiterer Miniaturisierung in Richtung Architektur und Aufbau der Chips. Durch das Stapeln von mehreren Chiplagen übereinander sollen beispielsweise noch höhere Leistungen erzielt werden. Dies hat allerdings zur Folge, dass sich die Entwicklungszyklen verlängern und ein Zeitraum von zwei Jahren nach Moore aktuell nicht mehr haltbar ist (Vgl. Gruber 2016).

Jason Dorrier schrieb im August 2020 auf SingularityHub hierzu:

Bis heute waren die Propheten des Untergangs verfrüht, und obwohl sich das Tempo verlangsamt, weicht die Branche dem Tod weiterhin mit kreativer Technik aus.

(Aus dem Englischen übersetzt, vgl. Dorrier 2020)

Auch wenn das „mooresche Gesetz“ demnach etwas an Schwung verloren hat, so sind die Grenzen der Leistungsfähigkeit noch lange nicht erreicht. Führende Hersteller haben vielerlei Ideen für innovative Mikroelektronik und testen neue Materialien als Ersatz für Silizium. Ohne die technologischen Fortschritte bei der Hardware wäre die Digitalisierung wie sie heute stattfindet, nicht möglich gewesen. Mikrochips werden immer kleiner, leistungsfähiger und gleichzeitig sogar preiswerter (Vgl. Gruber 2016).

Aber auch die Anwendungsfelder der Technologien haben sich ähnlich rasant entwickelt, wie die Hardware selbst (Vgl. Neugebauer 2018, S. 2). So gibt es heute eine Vielzahl an Programmen, Softwarelösungen und Apps, die auf beliebigen Plattformen und Geräten genutzt werden können.

Ausblick

Dieser Artikel basiert auf einem aktualisierten Auszug meiner Masterthesis. Der nächste Artikel wird sich mit der zeitlichen Einordnung des Begriffs der „Digitalisierung und Industrie 4.0“ befassen.

Hier geht’s zum Teil 2: https://www.frederikm.de/2021/01/05/digitalisierung-part-02-das-ist-doch-nichts-neues/

(Dieser Artikel erschien ursprünglich am 30. Dezember 2020 auf meinem LinkedIn-Account.)

Quellen:

- Brock, David C.; Moore, Gordon E. (2006): Understanding Moore’s law. Four decades of innovation. Philadelphia PA: Chemical Heritage Foundation. Online verfügbar unter https://www.sciencehistory.org/sites/default/files/understanding_moores_law.pdf, zuletzt geprüft am 30.12.2020.

- Gruber, Angela (2016): Physikalische Grenze der Chip-Entwicklung: Kleiner geht’s nicht. Spiegel Online. Hamburg. Online verfügbar unter http://www.spiegel.de/netzwelt/web/moore-s-law-die-goldene-regel-der-chiphersteller-broeckelt-a-1083468.html, zuletzt aktualisiert am 26.03.2016, zuletzt geprüft am 30.12.2020.

- Markoff, John (2011): The iPad in Your Hand: As Fast as a Supercomputer of Yore. New York Times. Online verfügbar unter https://bits.blogs.nytimes.com/2011/05/09/the-ipad-in-your-hand-as-fast-as-a-supercomputer-of-yore/, zuletzt aktualisiert am 21.05.2018, zuletzt geprüft am 07.10.2018.

- Neugebauer, Reimund (2018): Digitale Information. der „genetische Code“ moderner Technik. In: Reimund Neugebauer (Hg.): Digitalisierung. Schlüsseltechnologien für Wirtschaft und Gesellschaft. 1. Auflage. Berlin, Heidelberg: Springer Vieweg (Fraunhofer-Forschungsfokus), S. 1–7.

- Schadhauser, Walter (2018): Was ist das „Ende von Moores Law“? Vogel Communications Group GmbH & Co. KG. Online verfügbar unter https://www.storage-insider.de/was-ist-das-ende-von-moores-law-a-730124/, zuletzt geprüft am 07.10.2018.

- Dorrier, Jason (2020): Moore’s Law Lives: Intel Says Chips Will Pack 50 Times More Transistors. SingularityHub. Online verfügbar unter https://singularityhub.com/2020/08/23/moores-law-lives-intel-says-chips-will-pack-50-times-more-transistors/, zuletzt aktualisiert am 23.08.2020, zuletzt geprüft am 30.12.2020.

1 Gedanke zu „#Digitalisierung (Part 01) – Die Anfänge des digitalen Zeitalters“